DETReg: Unsupervised Pretraining With Region Priors for Object Detection

DETReg: Unsupervised Pretraining With Region Priors for Object Detection

CVPR 2022, 2024-04-18 기준 115회 인용

Task

- Object Detection

- DETR

Contribution

- UP-DETR 과 마찬가지로 DETR에서 Transformer module 부분을 pre-training 하겠다는 논문

- UP-DETR 은 random cropping 해서 학습에 사용하기 때문에 object의 위치가 고려되지 않은채 학습된다

- 이를 해결하기 위한 object-centric and category-agnostic pretraining 방법을 제안

Motivation

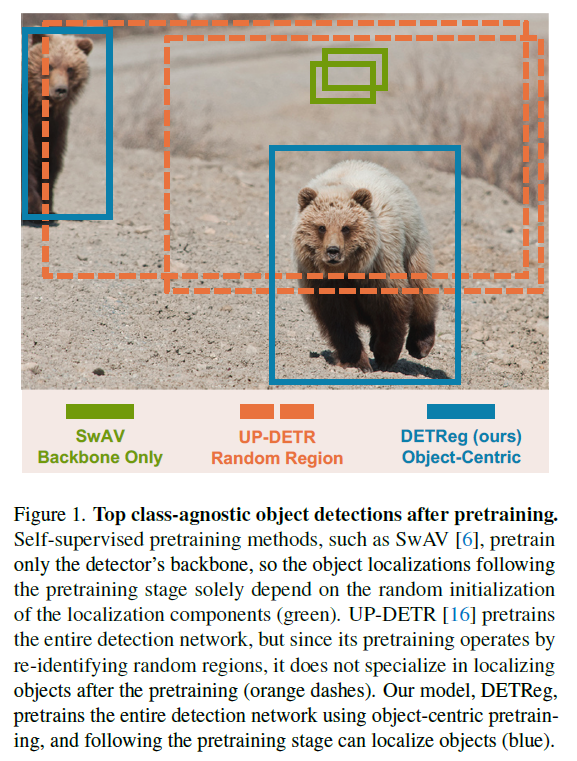

Pre-trained 된 model 들에 대한 object detection 결과 (not fine-tuned)

Backbone 만 pre-training 했을 때는 전혀 다른 부분을 prediction

UP-DETR 도 object 와 무관한 부분을 detection

DETReg 는 object를 detection

Proposed Method

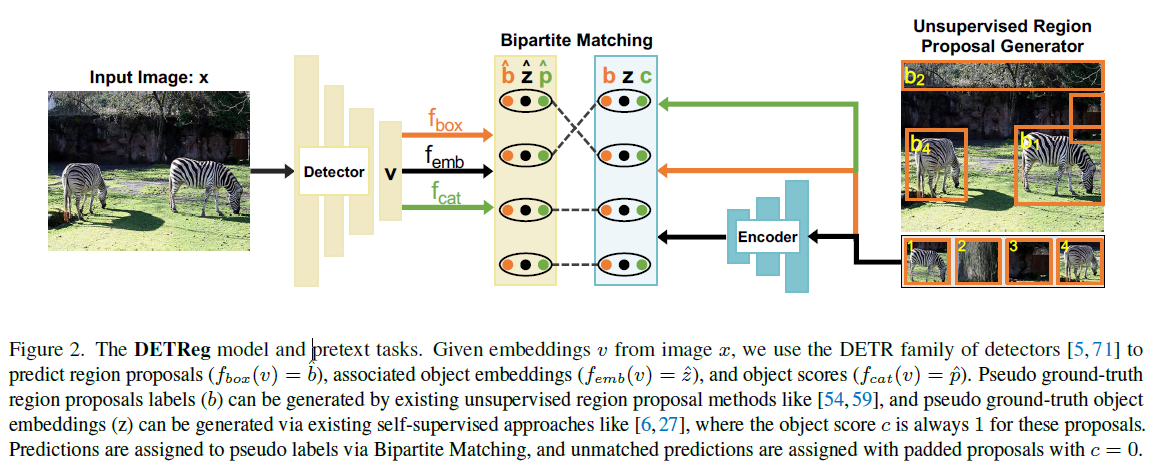

Object Localization Task

object-centric pre-training 을 위해

Selective search 사용 → 물체가 있을법한 위치를 찾는다

Selective Search uses object cues such as continuity in color and edges to extract object proposals

이를 통해서 class-agnostic 학습 가능 (class 와 상관없이 object가 있을법한 곳일 찾기 때문에)

Top-K 를 선택

본 논문에서는 K=30 사용

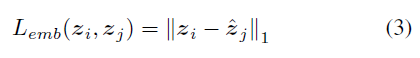

Object Embedding Task

In the supervised training of object detectors, every box is associated with a class category of the object, which is not available in an unsupervised setting.

Object embedding 을 학습하기 위한 부분

self-supervised learning 분야에서 제안된 SwAV를 pretrained model 로 사용 (UP-DETR 과 동일)

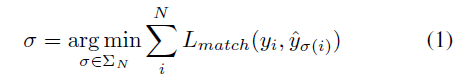

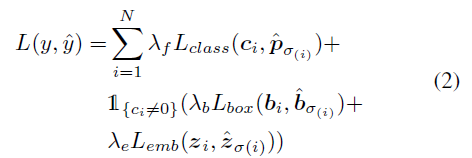

기존 DETR matching 과 동일

pseudo ground-truth 랑 매칭되었을 때는 class =1, 나머지 매칭에 대해서는 0

SwAV pretrained model 로 부터 얻어지는 embedding 값을 ground-truth

마지막 decoder layer 결과로부터 MLP를 통과시키고 이를 object embedding prediction으로 사용

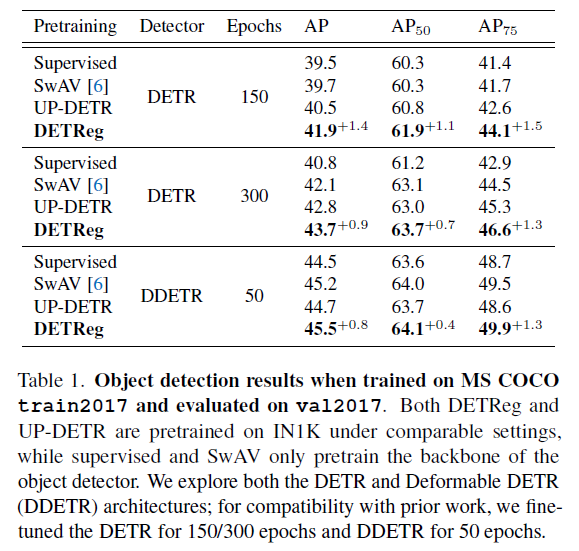

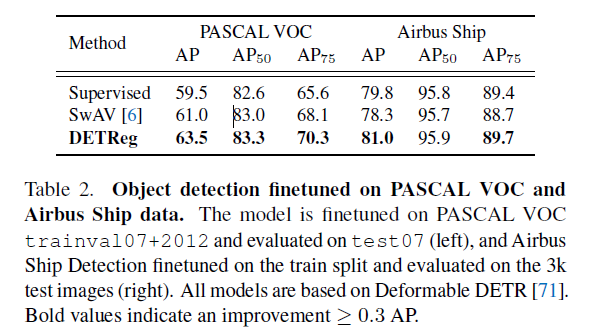

Experimental Results

COCO dataset 에 대한 실험 결과

PASCAL VOC 과 Airbus Ship data 에 대한 실험 결과