Dense Distinct Query for End-to-End Object Detection

Dense Distinct Query for End-to-End Object Detection

CVPR 2023, 2024-04-23 기준 41회 인용

Task

- Object Detection

- DETR

Contribution

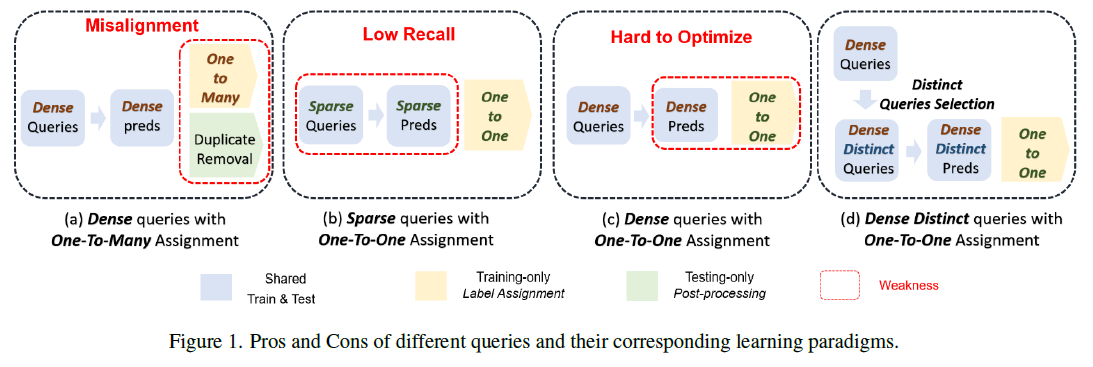

- Sparse queries 들은 high recall 을 보장해주지 못한다

- 반면에 Dense queries 들은 서로 비슷한 query 들로 인해서 최적화가 어렵다

- Sparse 와 Dense 가 가져갈 수 있는 장점들을 혼합한 Dense Distinct Queries (DDQ) 를 제안

Proposed Method

Analysis of Sparse and Dense Queries

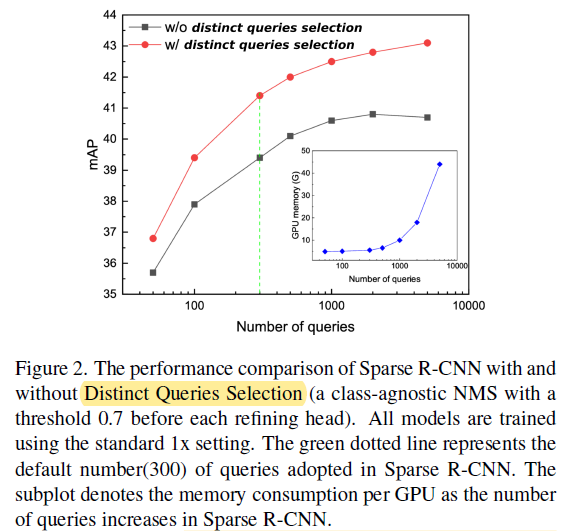

Sparse R-CNN 에서 쿼리를 증가할 수록 성능 향상이 플랫하게 된다

제안한는 방법을 적용하면 성능이 개선된다

저자들의 가정

potentially representing the same instance

비슷한 역할을 하는 쿼리들이 서로 다른 label 에 할당받게 되었을 때 학습이 어려울 것이다

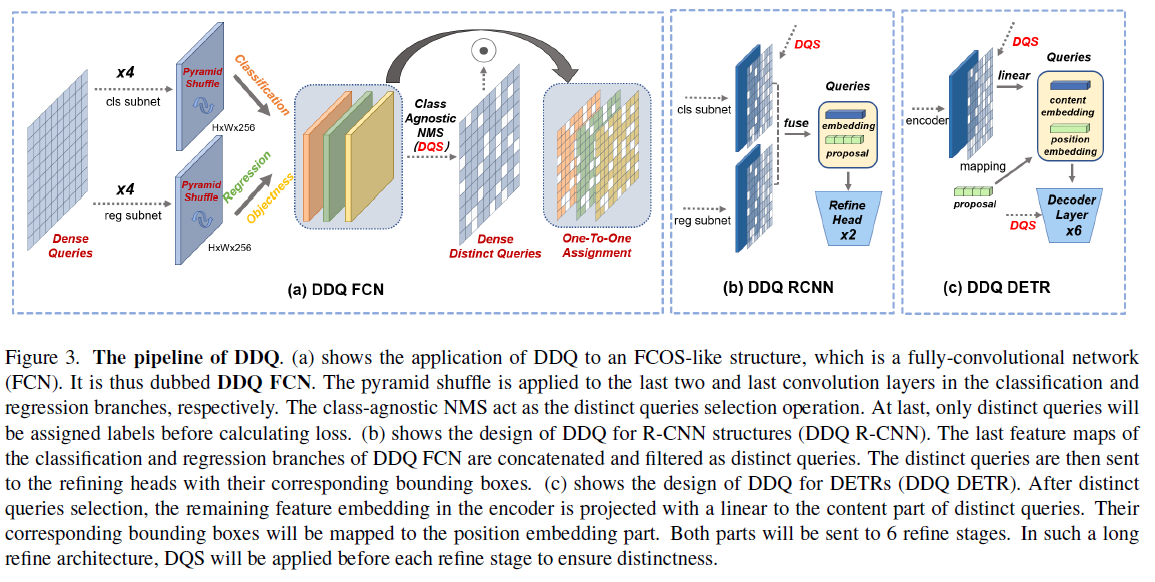

Distinct Queries Selection (DQS)

Class Agnostic NMS

IoU threshold (0.7 in DDQ FCN and DDQ R-CNN, 0.8 in DDQ DETR)

Therefore, such a pipeline still abides by the definition of end-to-end detectors.

기존에는 inference 에만 NMS를 썼으니 Training 과정에서도 사용하겠다

K개 select

Auxiliary Loss for Dense Queries

DQS 로 쿼리를 filter 하게 되면 no gradient 되는 부분이 많아진다

이를 보완하기 위해서 Dense Queries 에 soft one-to-many 를 도입

supplementary 에 명확하게 서술되어 있는 것 같지 않지만.. filter 전 쿼리들에 대한 값을 soft target label 로 학습

classification 과 IoU 값을 곱한 것으로 soft label

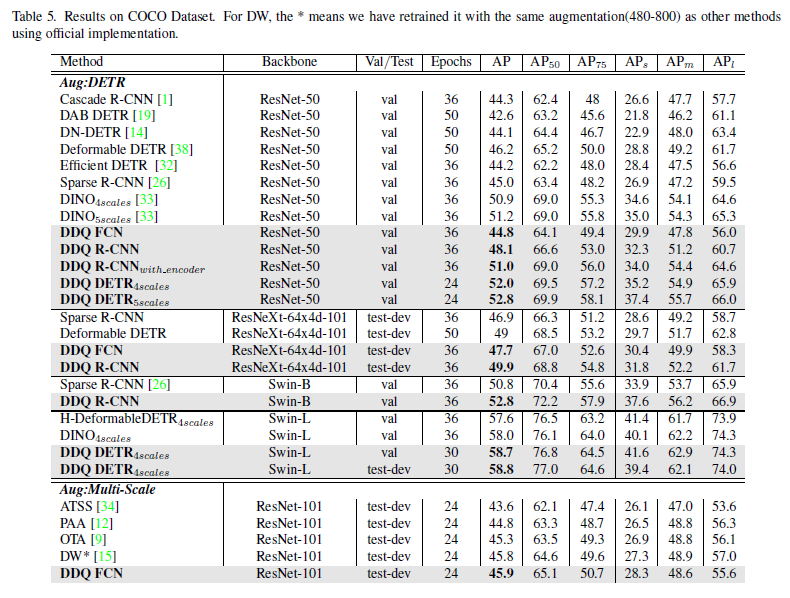

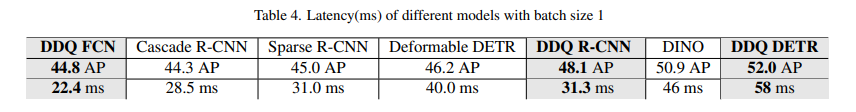

Experimental Results

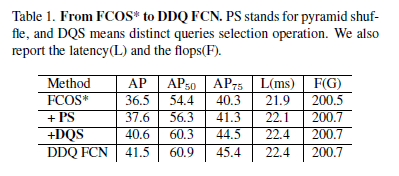

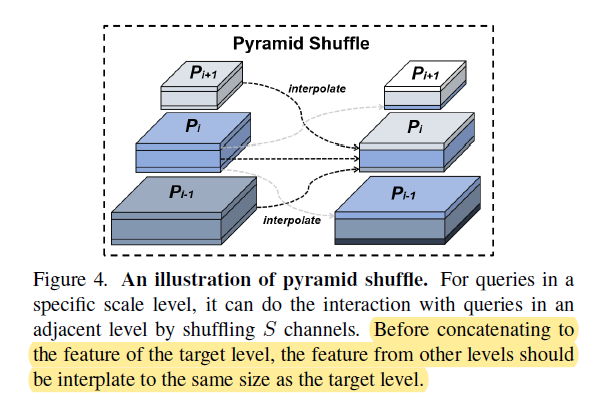

PS - pyramid shuffle

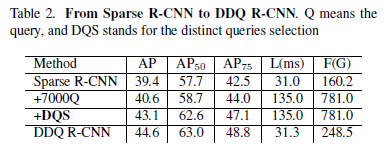

DQS - Distinct Queries Selection

FCOS 에 추가했을 때 성능이 향상 된다

Sparse R-CNN 에도 향상이 된다

명확한 설명이 없지만 +DQS 는 Sparse R-CNN 은 refine 을 6stage 이지만 DDQ 에서는 2stage 만 진행

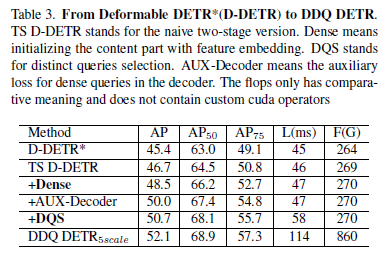

Deformable DETR 에 적용

성능 향상되지만 시간이 크게 증가하는 것을 볼 수 있다

성능 자체는 향상되지만 시간은 증가할 수 밖에 없다